Historia de la Inteligencia Artificial

Génesis de la Inteligencia Artificial - 1943

|

| Warren McCulloch y Walter Pitts |

Warren McCulloch y Walter Pitts son los autores del primer trabajo de IA, basándose en 3 fuentes: fisiología básica, y funcionamiento de las neuronas en el cerebro, la lógica proposicional(Russell y Withehead) y la teoría de la computación de "Turing". Diseñaron un modelo construido por neuronas artificiales, en el que cada una de ellas debería de estar activada o desactivada; la activación se daba como respuesta, a la estimulación producida por una cantidad suficiente de neuronas vecinas. El estado de una neurona se veía como "equivalente, de echo a una proposición con unos estímulos adecuados”. Mostraron que cualquier función de cómputo podría realizarse mediante una red de neuronas interconectadas y que todos los conectores lógicos se podían implementar utilizando estructuras de red sencillas; También sugirieron que redes adecuadamente definidas podrían aprender.

| Donald Hebb |

Donald Hebb propuso y demostró una sencilla regla de actualización para modificar las intensidades de las conexiones entre neuronas. Esta regla sigue vigente en la actualidad pero se conoce con el nombre de aprendizaje "Hebbiano".

| Marvin Minsky y Dean Edmonds |

2 estudiantes graduados en el departamento de matemáticas de Princeton Marvin Minsky y Dean Edmonds construyeron el primer computador a partir de una red neuronal de 1951, llamado SNARC el cual tenía un mecanismo de piloto automático obtenido de los desechos de un avión bombardero B-24 para simular una red con 40 neuronas. El comité encargado de evaluar el doctorado de Minsky veía con escepticismo el que este tipo de trabajo pudiera considerarse como matemático, pero "Bole Newman" dijo "si no lo es actualmente algún día lo será". Minsky posteriormente probó teoremas influyentes que mostraron las limitaciones de la investigación con redes neuronales.

| Alan Turing |

Hay un número de trabajos iniciales que se pueden caracterizar como de IA pero fue "Alan Turing" quien articulo por primera vez una visión de la IA en su trabajo Computin machineri an inteligence en 1950. Ahí introdujo la prueba de Turing , el aprendizaje automático , los algoritmos genéricos y el aprendizaje por refuerzo.

El más famoso fue el mundo de los bloques, que consiste en un conjunto de bloques sólidos colocados sobre una mesa. Una tarea típica de este mundo es la re-ordenación de los bloques de cierta manera, con la ayuda de la mano de un robot que es capaz de tomar un bloque cada vez.

Nacimiento de la inteligencia Artificial – 1956

Princeton acogió a otros de las figuras de la IA, como es el caso de John McCarthy que quien posteriormente a su graduación se trasladó al colegio de Dartmouth , que se erigiría en el lugar de nacimiento oficial de este campo. McCarthy convenció a Minsky, Claude ,Shannon y Natalie Rochertter para que le ayudaran a aumentar el interés de los investigadores americanos en la teoría de autómatas , las redes neuronales y el estudio de la inteligencia.

Organizaron un taller con una duración de dos meses en el verano de 1956 en el colegio de Dartmouth tal cual hubo en total 10 asistentes, entre los que se encontraban Trenchard More de Princeton , Arthur Samuelde IBM y Ray Solomonoff y Oliver Selfride de MIT. Dos investigadores del Carnegie Tech, Allen Newell y Hebert Simon. Acapararon la atención. Si bien los demás también tenían algunas ideas y, en algunos casos, programas para aplicaciones determinadas como el juego de damas. Newell y Simon contaban ya con el programa de razonamiento el Teórico lógico, del que Simon afirmaba: "hemos inventado un programa de computación capaz de pensar de manera no numérica, con lo que ha quedado resuelto el venerable problema de dualidad mente-cuerpo".

El taller de Dartmounth no produjo ningún avance significativo pero puso en contacto a las figuras importantes .Durante los siguientes 20 años el campo estuvo dominado por estos personajes así como por sus estudiantes y colegas del MIT, CMU, Stanfford e IBM. Lo último que surgió del taller fue el consenso en adoptar el nuevo nombre propuesto por McCarthy para este campo: Inteligencia Artificial. Quizás la racionabilidad computacional hubiese sido más adecuado pero IA se a mantenido.

Como conclusiones del taller se determina que la IA es un área "separada" no dependiente de ninguna otra ya que desde el primer momento abarco la idea de duplicar facultades humanas como la creatividad, la auto mejora y el uso del lenguaje. Ninguno de los otros campos tenía en cuenta esos temas y por otro lado la metodología de IA es diferente, claramente des una rama de la informática que persigue la construcción de máquinas que funcionen automáticamente en medios complejos y cambiantes.

2.- Artículo titulado. Program with common sense, en el que describía el generador de consejos, un programa hipotético que podría considerarse como el prime sistema de IA completo. Al igual que el teórico lógico y el demostrador de teoremas de geométrica, McCarthy diseño su programa para buscar la solución a problemas utilizando el conocimiento. Pero a diferencia de los otros, manejaba el conocimiento general del mundo. Por ejemplo, monstruo como algunos axiomas sencillos permitían a un programa generar un plan para conducirnos hasta el aeropuerto y tomar un avión. El programa se diseñó para que aceptarse nuevos axiomas durante el curso normal de operación, permitiéndole así ser competente en áreas nuevas, sin necesidad de reprogramación. El Generador de consejos incorporaba así los principios centrales de la representación formal y explicita del mundo y de la forma en que la acción de un agente afecta al mundo, así como, ser capaces de manipular estas representaciones con procesos deductivos. Es sorprendente constatar como mucho de lo propuesto en el artículo escrito en 1958 permanece vigente incluso en la actualidad.

3.- 1958 fue el año en que Marvin Minsky se trasladó al MIT. Sin embargo, su colaboración inicial no duro demasiado. McCarthy se centró en la representación y el razonamiento con lógica formal, mientras que Minsky estaba más interesado en lograr que los programas funcionaran y eventualmente desarrollo un punto de vista anti-lógico.

En 1953 McCarthy creo el laboratorio de IA en Stanford. Su plan para construir la versión mas reciente del generador de Consejos con ayuda de la lógica sufrió un considerable impulso gracias al descubrimiento de J.A. Robinson del método de resolución, lo cual era un algoritmo completo para la demostración de teoremas para la lógica de primer orden. El trabajo realizado en Stanford hacia énfasis en los métodos lógicos incluían los sistemas de planificación y respuesta a preguntas de Cordell Green (1969), así como el proyecto de robótica de Shakey en el nuevo instituto de Investigación de Stanford (Stanford Research institute SRI). Este proyecto fue el primer que demostró la total integración del razonamiento lógico y la actividad física.

Minsky superviso el trabajo de una serie de estudiantes que eligieron un número de problemas limitados cuya solución pareció requerir inteligencia. Estos dominios limitados se conocen como "micromundos".El programa SAINT de James Slagle (1963) fue capaz de resolver programas de integración de cálculo cerrada , habituales a los primeros cursos de licenciatura.

Grandes Esperanzas 1952-1969

1.- 1952 Arthur Samuel escribió una serie de programas para el juego de las damas que eventualmente aprendieron a jugar hasta alcanzar un nivel equivalente de un amateur.2.- Artículo titulado. Program with common sense, en el que describía el generador de consejos, un programa hipotético que podría considerarse como el prime sistema de IA completo. Al igual que el teórico lógico y el demostrador de teoremas de geométrica, McCarthy diseño su programa para buscar la solución a problemas utilizando el conocimiento. Pero a diferencia de los otros, manejaba el conocimiento general del mundo. Por ejemplo, monstruo como algunos axiomas sencillos permitían a un programa generar un plan para conducirnos hasta el aeropuerto y tomar un avión. El programa se diseñó para que aceptarse nuevos axiomas durante el curso normal de operación, permitiéndole así ser competente en áreas nuevas, sin necesidad de reprogramación. El Generador de consejos incorporaba así los principios centrales de la representación formal y explicita del mundo y de la forma en que la acción de un agente afecta al mundo, así como, ser capaces de manipular estas representaciones con procesos deductivos. Es sorprendente constatar como mucho de lo propuesto en el artículo escrito en 1958 permanece vigente incluso en la actualidad.

3.- 1958 fue el año en que Marvin Minsky se trasladó al MIT. Sin embargo, su colaboración inicial no duro demasiado. McCarthy se centró en la representación y el razonamiento con lógica formal, mientras que Minsky estaba más interesado en lograr que los programas funcionaran y eventualmente desarrollo un punto de vista anti-lógico.

En 1953 McCarthy creo el laboratorio de IA en Stanford. Su plan para construir la versión mas reciente del generador de Consejos con ayuda de la lógica sufrió un considerable impulso gracias al descubrimiento de J.A. Robinson del método de resolución, lo cual era un algoritmo completo para la demostración de teoremas para la lógica de primer orden. El trabajo realizado en Stanford hacia énfasis en los métodos lógicos incluían los sistemas de planificación y respuesta a preguntas de Cordell Green (1969), así como el proyecto de robótica de Shakey en el nuevo instituto de Investigación de Stanford (Stanford Research institute SRI). Este proyecto fue el primer que demostró la total integración del razonamiento lógico y la actividad física.

Minsky en 1963 creo el laboratorio de IA en Stanford. Su plan para construir la versión mas reciente del generador de consejos con ayuda de la lógica sufrió un considerable impulso gracias al descubrimiento de J.A. Robinson del método de resolución, lo cual era un algoritmo completo para la demostración de teoremas para la logia de primer orden. El trabajo realizado Stanfford hacia énfasis en los métodos de propósito general para el razonamiento lógico. Algunas aplicaciones de la lógica incluían los sistemas de planificación respuestas a preguntas de Cordell Green(1969b),así como el proyecto de robótica de Shakey en el nuevo instituto del investigación de Stanford (Stanford Research institude SRI). Este proyecto fue el primero que de mostró la total integración del razonamiento lógico y la actividad física.

Minsky superviso el trabajo de una serie de estudiantes que eligieron un número de problemas limitados cuya solución pareció requerir inteligencia. Estos dominios limitados se conocen como "micromundos".El programa SAINT de James Slagle (1963) fue capaz de resolver programas de integración de cálculo cerrada , habituales a los primeros cursos de licenciatura.

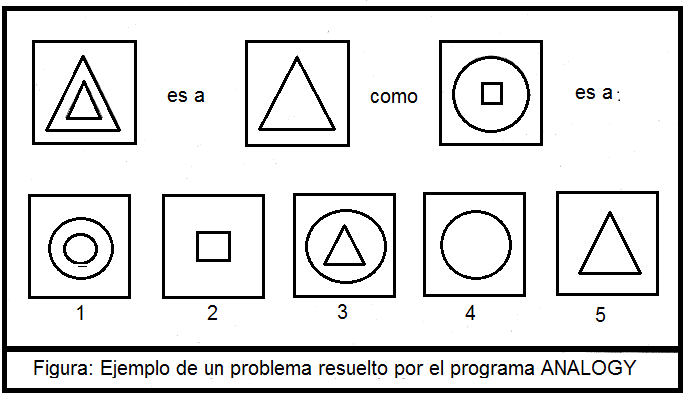

El programa ANALOGY de Tom Evans (1968) resolvía problemas de analogía geométrica que se aplicaban pruebas de medición de inteligencia, semejante a la figura siguiente.

El programa STUDENT de Daniel Bobrow (1967) podía resolver problemas de algebra de tipo:

Si el número de cliente de Tom es dos veces el cuadrado del 20 por ciento de la cantidad de anuncios que realiza, y estos ascienden a 45 ¿Cuantos clientes tiene tom?

Clientes = C

c=2(45*.20)2 =162

El más famoso fue el mundo de los bloques, que consiste en un conjunto de bloques sólidos colocados sobre una mesa. Una tarea típica de este mundo es la re-ordenación de los bloques de cierta manera, con la ayuda de la mano de un robot que es capaz de tomar un bloque cada vez.

| Daniel Bobrow |

El mundo de los bloques fue el punto de partida para el proyecto de visión de David Huffman (1971), la visión y el trabajo de propagación con restricciones de David Waltz(1975), la teoría del aprendizaje de Patrick Winston (1970), del programa para la comprensión del lenguaje natural de Terry Winogrand (1972) y el planificador de Scott Fahlman (1974).

| McCulloch y Pitts |

El trabajo realizado por McCulloch y Pitts con redes neuronales hizo florecer esta línea. El trabajo de Winograd y Cowan (1963) monstruo como un gran número de elementos, podría representar un concepto individual de forma colectiva, lo cual llevaba consigo un aumento proporcional en robustez y paralelismo. Los métodos de aprendizaje de Hebb se reforzaron con las aportaciones de Bernie Widrow y Hoff (1962), quien llamo adalides a sus redes, y por Frank Rosenblatt (1962) con sus perceptores. Rosenblatt demostró el famoso teorema del perceptor, con lo que demostró, que su algoritmo de aprendizaje podría ajustar las intensidades de las conexiones de un perceptor para que se adaptaran a los datos de entrada, siempre y cuando existiera una correspondencia.

Una dosis de realidad (1966 – 1973)

Desde el principio, los investigadores de IA hicieron públicas, sin timidez, predicciones sobre el éxito que esperaba.

|

| Hebert Simon |

Con frecuencia, se cita el siguiente comentario realizado por Hebert Simon en 1957:

"Sin afán de sorprenderlos y dejarlos atónitos, pero la forma más sencilla que tengo de resumirlo es diciéndoles que actualmente en el mundo existen maquinas capaces de pensar, aprender y crear. Además, su aptitud para haber lo anterior aumentara rápidamente hasta que(en un futuro previsible) la magnitud de problemas serán capaces de resolver e ir a la par de la capacidad de la mente humana para hacer lo mismo."

Términos como "Futuro previsible" pueden interpretarse de formas distintas, pero Simón también hizo predicciones concretas: como que en diez años un computador llegaría a ser campeón de ajedrez y que podría demostrar un importante teorema matemático con una máquina. Estas predicciones se cumplirían dentro de 40 años (una parte) y no diez años el exceso de confianza de Simón se debió a la prometedora actuación de los primeros sistemas de Allen problemas simples.

El primer tipo de problemas surgió debido a que estos problemas contaban con poco o ningún conocimiento de la materia objeto de estudio: obtenían resultados gracias a sencillas manipulaciones sintácticas. Una anécdota típica tuvo lugar cuando se comenzaba a trabajar con la traducción automática, actividad que recibía un generoso patrocinio del Consejo Nacional para la Investigación de Estados Unidos en un intento de agilizar la traducción de artículos científicos rusos en vísperas del lanzamiento del Sputnik en 1957.

| Sputnik |

Al principio se consideró que todo se reduciría a sencillas transformaciones sintácticas apoyadas en las gramáticas rusas e inglesa y el emplazamiento de las palabras mediante un diccionario electrónico, lo que bastaría para obtener un significado exacto de las oraciones. La realidad es que para traducir es necesario contar con el conocimiento general sobre el tema, que permita resolver ambigüedades y así precisar el contenido de una oración.

La famosa re-traducción del ruso al inglés se la frase "espíritu fuerte pero la carne es débil", cuyo resultado fue:

"El vodka es bueno pero la carne es podrida” es un buen ejemplo de las dificultades que surgieron.

En un informe presentado en 1996 el comité consultivo que "nos se ha logrado obtener ninguna traducción de los textos científicos generales ni se prevé obtener ninguna en un futuro inmediato" se canceló todo el patrocinio del gobierno estadounidense que se había asignado a los proyectos académicos sobre traducción. Hoy día, la traducción automática es una herramienta imperfecta paro de uso extendido en documentos técnicos, comerciales, gubernamentales y de internet.

Aunque la informática había abandonado de manera general el campo de las redes neuronales a finales de los años 70, el trabajo continúo en otros campos. Físicos como John Hopfield (1982) utilizaron técnicas de la mecánica estadística para analizar las propiedades de almacenamiento y optimización de las redes, tratando colecciones de nodos como colecciones de átomos. Psicólogos como David Rumelhart y Geoff Hinton continuaron con el estudio de modelos de memoria basados en redes neuronales. El impulso más fuerte se produjo a mediados de la década de los 80, cuando por lo menos a cuatro grupos distintos reinventaron el algoritmo de aprendizaje de retroalimentación, mencionado por vez primera en 1969 por Bryson y Ho. El algoritmo se aplicó a diversos problemas de aprendizaje en los campos de la informática y la psicología, de la cual se hizo una gran difusión par que se conocieran los resultados obtenidos, publicados en la colección Parallel Distributed Processing (Rumelhart y McClelland, 1986) lo que suscitó un entusiasmo.

Aquellos

modelos de inteligencia artificial llamados “conexionistas” fueron vistos por

algunos como competidores tanto de los modelos como simbólicos propuestos por

Newell y Simón como da la aproximación lógica de McCarthy entre otros

(Smolensky, 1988). Puede parecer obvio que los humanos manipulan símbolos hasta

cierto nivel, de hecho, el libro The Simbolics Species (1997) de Terrence

Deacon sugiere que esta es la característica que define a los humanos, pero los

conexionistas más ardientes se preguntan si la manipulación de los símbolos

desempeña algún papel justificable en determinados modelos de cognición. Esta

interrogante no a sido muy clarificada, pero la tendencia actual es que las

aproximaciones conexionistas y simbólicas son complementarias y no

competidoras.

La IA se Convierte en Industria (1980).

(1982) El primer sistema experto comercial que tuvo

éxito, R1, inicio su actividad en Digital Equipment Corporation (McDermott)

En 1982 los japoneses anunciaron el proyecto quinta generación un plan de diez respuestas estados unidos constituyo la microelectronics and computer technology corporation(MCC), consorcio encargado de mantener la competitividad nacional en estas áreas.

En su conjunto la industria de la IA creció rápidamente , pasado de unos pocos millones de dólares en 1980 a billones de dólares en 1988.

1986 representaba para la compañía un ahorro estimado de 40 millones de dólares al año. en 1988, el grupo de inteligencia artificial de DEC había distribuido ya 40 sistemas expertos, y había mas en camino.

(1988)

El grupo de Inteligencia artificial de DEC había distribuido ya 40 sistemas

expertos, y había mas en camino. Du Pont utilizaba ya 100 y estaban en etapa de

desarrollo 500 más, lo que generaba ahorro de diez millones de dólares anuales

aprox.

La industria de la IA creció rápidamente, pasando de unos pocos millones de dólares en 1980 a billones de dólares en 1988.

Regreso de las redes neuronales (desde

1986 hasta el presente)

Aunque la informática había abandonado de manera general el campo de las redes neuronales a finales de los años 70, el trabajo continúo en otros campos. Físicos como John Hopfield (1982) utilizaron técnicas de la mecánica estadística para analizar las propiedades de almacenamiento y optimización de las redes, tratando colecciones de nodos como colecciones de átomos. Psicólogos como David Rumelhart y Geoff Hinton continuaron con el estudio de modelos de memoria basados en redes neuronales. El impulso más fuerte se produjo a mediados de la década de los 80, cuando por lo menos a cuatro grupos distintos reinventaron el algoritmo de aprendizaje de retroalimentación, mencionado por vez primera en 1969 por Bryson y Ho. El algoritmo se aplicó a diversos problemas de aprendizaje en los campos de la informática y la psicología, de la cual se hizo una gran difusión par que se conocieran los resultados obtenidos, publicados en la colección Parallel Distributed Processing (Rumelhart y McClelland, 1986) lo que suscitó un entusiasmo.

IA se Convierte en una Ciencia(1987-presente).

En los últimos años se ha producido una revolución tanto como en el contenido como en la metodología de trabajo en el campo de la IA. Actualmente es más usual el desarrollo sobre teorías ya existentes que proponer teorías totalmente novedosas, se toman como base rigurosas teoremas o solidas evidencias experimentales más que intuición , también se demuestra la unidad de las aplicaciones en el mundo real más que crear ejemplos de juguete.

La IA se fundó en parte al marco de la rebelión en contra de las limitaciones de los campos existentes como la teoría de control o la estadística , y ahora abarca estos campos. Tal y como indica David McAllester(1998).

"En los primeros años de la IA parecía posible que las nuevas formas de la computación simbólica por ejemplo:

Los marcos y las nuevas formas de la computación simbólica por ejemplo los marcos y las redes semánticas, hicieron que la mayor parte de la teoría clásica pasara a ser obsoleta.

Esto llevo a la IA a una especia de aislamiento, que la separo del resto de las ciencias de computación.

En la actualidad se está abandonando este aislamiento, existe la creencia de que el aprendizaje automático no se debe separar de la teoría de la información , que el razonamiento incierto no se debe separar de los modelos estocásticos , que la búsqueda no se debe aislar de la optimización clásica y el control , y de que el razonamiento automático no se debe separar de los métodos formales y análisis estático."

En términos metodológicos , se puede decir , con la rotundidad que la IA ya forma parte del ámbito de los métodos científicos .Para que se acepten las hipótesis se deben someter rigurosos experimentos empíricos, y los resultados deben analizarse estadística-mente para identificar su relevancia (Cohen 1995). El uso del internet y el compartir repositorios de datos de prueba y código, ha hecho lo posible que ahora se puedan contrastar estos conocimientos.

Un buen modelo de la tendencia actual es el campo del reconocimiento del habla.

En la década de los 70's se sometió a una prueba una gran variedad de arquitecturas y enfoques. Muchos de ellos un tanto ad hoc y resultan frágiles, y fueron probados solo en unos pocos ejemplos elegidos específicamente. En años recientes, las aproximaciones basadas en los modelos de MARCOV ocultos MMO han pasado a dominar el área. Dos son características de los MMO que tienen relevancia.

-Primero se basan en una rigurosa teoría matemática, lo cual ha permitido a los investigadores del lenguaje basarse en resultados de investigaciones matemáticas hechas en otros campos a lo largo de varias décadas.

-En Segundo lugar, los modelos de han generado durante un proceso de aprendizaje en grandes corpus de daros de lenguajes reales. Lo cual garantiza una funcionalidad robusta y en sucesivas pruebas ciegas, los MMO han mejorado sus resultados del conocimiento de caracteres manuscritos están actualmente en transición hacia una generalidad utilización en aplicaciones de consumo.

Las redes neuronales también siguen esta tendencia. Mayor parte del trabajo realizado con redes neuronales en la década de los 80 se realizó con la idea de dejan a un lado lo que se podía hacer y descubrir en que se diferencias las redes neuronales de otras técnicas "tradicionales". La utilización de metodologías mejoradas y marcos teóricos ha autorizado que este campo alcance un grado de conocimiento que ha permitido que las redes neuronales se puedan comparar con otras técnicas similares de estos campos como la estadística, el reconocimiento de patrones y el aprendizaje automático de forma que las técnicas más prometedoras pueden aplicarse a cualquier problema. Como resultado de estos desarrollos la tecnología denominada minería de datos ha generado una nueva y rigurosa industria.

La aparición de Probalabilistic Reasoning in Intelligent Sysems de Judea Pearl(1988) hizo que se aceptara de nuevo la probabilidad y la teoría de la decisión como parte de la IA , como consecuencia del surgimiento del interés despertado y gracias especialmente al artículo in Defence Of Probality de Peter Cheeseman(1985).

El formalismo de las redes de Bayes apareció para facilitar la representación eficiente y el razonamiento riguroso en situaciones en las que se disponía de conocimiento incierto. Este enfoque supera con creces muchos de los problemas de los sistemas de razonamiento probabilístico de las décadas de los 60 y 70; y ahora domina la investigación de la IA en el razonamiento incierto y los sistemas expertos. Esta aproximación de la IA clásica y las redes neuronales. En el trabajo de Judea Pearl(1982)y de Eric Horvitz y David Heckerman(1986) sirvió para promover la noción de los sistemas expertos normativos , es decir ,los que actúan racionalmente de acuerdo con las leyes de la teoría de la decisión, sin que intenten imitar las etapas de razonamiento de os expertos humanos. El sistema operativo Windows incluye varios sistemas expertos de diagnóstico normativos para la corrección de problemas.

Revoluciones similares y suaves se han dado la robótica, visión por computador, y aprendizaje automático. La comprensión mejor de los problemas y de su complejidad, junto a un complemento de sofisticación de las matemáticas ha facilitado el desarrollo de una agenda de investigación y métodos más robustos. En cualquier caso, la formalización especialización ha llevado también a la fragmentación: arias como la visionó y la robótica están cada vez más aislados de la "rama central" de la IA . La concepción unificadora de la IA como diseño de agentes racionales puede facilitar la unificación de estos campos diferentes.

Emergencia de los sistemas inteligentes (desde 1995 hasta el presente).

Quizás animados por el progreso en la resolución de sub-problemas de IA, los investigadores han comenzado a trabajar de nuevo con el problema del "agente total" . El trabajo de Allen Newell ,John y Paul Rosenbloom en SOAR(1987) es el ejemplo mejor conocido de la arquitectura de agente completa . El llamado "movimiento situado" intenta de entender la forma de actuar de los agentes inmersos en los entornos reales, que disponen los sensores de entradas continuas. Unos de los medios más importantes para los agentes inteligentes es internet. Los sistemas de IA han llegado a ser comunes en aplicaciones desarrolladas en la web que el sufijo "--bot" se ha introducido en el lenguaje común. Más aun, tecnologías de IA son la base de muchas herramientas para internet , como por ejemplo los motores de búsqueda ,sistemas de recomendación y los sistemas de para la construcción de portales web.

Una de las conclusiones que se han extraído al tratar de construir agentes completos ha sido que se deberían reorganizarlos sub campos aislados de la IA para que sus resultados se puedan interrelacionar. En particular, ahora se cree mayoritariamente que los sistemas sensoriales (visión, sonar, reconocimiento de voz...) no pueden generar información totalmente fidedigna del medio que habitan. Otra segunda consecuencia importante, desde la perspectiva del agente, que es la IA se ha ido acercando a otros campos, como la teoría de control y la economía, que también tratan con agentes.

Referencias:

http://timerime.com/es/evento/3852138/La+IA+se+convierte+en+una+industria/

http://timerime.com/es/evento/3849735/La+IA+se+convierte+en+una+industria/

Comentarios

Publicar un comentario